UNIST, 소리 듣는 인공피부로 로봇 조종하는 기술 개발

- 가

달팽이관 모방해 다양한 주파수 영역 신호 선택적으로 인식

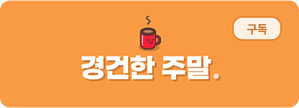

![[연구그림] 소리, 동작 인식 기능을 활용한 로봇 손 시연(아바타 로봇 분야에 센서를 응용한 실험). (A) 센서를 굽혔을 때의 정도에 따른 출력 전압 신호의 크기를 나타낸 그래프. (B) 사용자가 손가락 굽힘 정도를 바꿀 때 아바타 로봇손이 이를 따라 하는 모습. (C) 스마트 글러브에 5개의 마찰 전기 센서를 연결한 뒤, 블루투스 모듈로 연결하였을 때의 작동 사진. 각각의 손가락을 개별적으로 움직여 사용자의 동작을 따라 할 수 있다. (D) 일정 주파수에만 특정한 손가락 동작을 따라 하도록 인터페이스를 설계했을 때 로봇이 이를 따라 하는 사진. UNIST 제공](/nas/wcms/wcms_data/photos/2022/03/27/2022032719275656093_l.jpg) [연구그림] 소리, 동작 인식 기능을 활용한 로봇 손 시연(아바타 로봇 분야에 센서를 응용한 실험). (A) 센서를 굽혔을 때의 정도에 따른 출력 전압 신호의 크기를 나타낸 그래프. (B) 사용자가 손가락 굽힘 정도를 바꿀 때 아바타 로봇손이 이를 따라 하는 모습. (C) 스마트 글러브에 5개의 마찰 전기 센서를 연결한 뒤, 블루투스 모듈로 연결하였을 때의 작동 사진. 각각의 손가락을 개별적으로 움직여 사용자의 동작을 따라 할 수 있다. (D) 일정 주파수에만 특정한 손가락 동작을 따라 하도록 인터페이스를 설계했을 때 로봇이 이를 따라 하는 사진. UNIST 제공

[연구그림] 소리, 동작 인식 기능을 활용한 로봇 손 시연(아바타 로봇 분야에 센서를 응용한 실험). (A) 센서를 굽혔을 때의 정도에 따른 출력 전압 신호의 크기를 나타낸 그래프. (B) 사용자가 손가락 굽힘 정도를 바꿀 때 아바타 로봇손이 이를 따라 하는 모습. (C) 스마트 글러브에 5개의 마찰 전기 센서를 연결한 뒤, 블루투스 모듈로 연결하였을 때의 작동 사진. 각각의 손가락을 개별적으로 움직여 사용자의 동작을 따라 할 수 있다. (D) 일정 주파수에만 특정한 손가락 동작을 따라 하도록 인터페이스를 설계했을 때 로봇이 이를 따라 하는 사진. UNIST 제공

국내 연구진이 소리를 들을 수 있는 인공피부로 로봇을 조종하는 인터페이스 기술을 개발했다.

울산과학기술원(UNIST)은 고현협(에너지화학공학과) ·김재준(전기전자공학과) 교수 연구팀이 사람의 동작, 촉감, 소리 등을 인식해 기계에 전달하는 '사람-기계 인터페이스'를 개발했다고 27일 밝혔다.

이 인터페이스는 귓속의 달팽이관 구조를 모방한 인공피부 센서를 기반으로 한다.

두께, 다공성, 면적 등이 서로 다른 마찰 전기 센서 여러 개가 연속적으로 붙어 있는 형태다.

두께와 너비, 단단함 정도가 부위별로 다른 달팽이관 기저막이 소리를 주파수별로 구분해 받아들이는 원리를 응용했다.

센서의 이러한 특성 덕분에 사람의 동작처럼 느리게 반복되는 저주파 신호 뿐만 아니라 빠르게 진동하는 소리, 촉감 같은 고주파 신호도 낮은 신호 대 잡음비로 기계에 모두 전달할 수 있다고 연구팀은 설명했다.

연구팀은 또 센서 내부 구조를 특수하게 설계해 기존 평면 형태 센서보다 압력 민감도가 최대 8배 향상했다.

인식 주파수 대역폭도 45∼9000㎐(헤르츠)로 사람의 심전도 신호(0.5∼300㎐), 근전도 신호(50∼3000㎐), 심음도 신호(20∼2만㎐), 목소리(100∼400㎐)와 같은 생체 신호를 인식할 수 있다.

연구팀이 제작한 센서 사진. UNIST 제공

연구팀이 제작한 센서 사진. UNIST 제공

UNIST 연구진. (좌측 하단부터 반시계방향) 고현협 교수, 김재준 교수, 채희영 연구원, 강동희 연구원. UNIST 제공

UNIST 연구진. (좌측 하단부터 반시계방향) 고현협 교수, 김재준 교수, 채희영 연구원, 강동희 연구원. UNIST 제공

외부 소음 환경에서도 머신러닝을 통해 95% 정확도로 사람 목소리만 인식할 수 있다.

연구팀은 이 센서를 활용한 아바타 로봇 손 제어 기술, 스마트 햅틱 장갑 등 응용 기술을 선보였다.

소리로 아바타 로봇 손을 조종하는 시연에서는 주파수를 바꿔 손동작을 조종할 수 있었고, 사용자가 스마트 햅틱 장갑을 끼고 움직이면 아바타 로봇 손이 그대로 따라 했다.

유리, 종이, 실크 등 8가지 다른 물질의 질감도 93% 정확도로 인식했다.

연구팀 관계자는 "버튼이나 키보드를 누르는 대신 정보를 직관적으로 기계에 전달하는 방식의 사람-기계 인터페이스"라며 "센서가 얇고 부착 가능해 다양한 가상현실(VR), 증강현실(AR), 사물인터넷(IoT) 기술에 쓸 수 있을 것"이라고 말했다.

연구 결과는 미국과학협회(AAAS)에서 발행하는 '사이언스'(Science)의 자매지인 '사이언스 어드밴시스'(Science Advances)에 25일 자로 게재됐다.

연구는 미래창조과학부 중견연구자지원사업, 이엠텍, 포스코 사이언스 펠로십의 지원을 받아 이뤄졌다.

송현수 기자 songh@busan.com

당신을 위한 AI 추천 기사

실시간 핫뉴스